低品質なコンテンツの存在は、ウェブサイトにとってSEOのマイナス要因です。低品質なコンテンツを削除または改善し、サイト内のすべてのコンテンツを高品質に保つことで、SEOの効果を最大にすることができます。この記事では主に中小企業を対象に、企業サイトのコンテンツの品質管理について解説します。

目次

改善または削除の必要性

低品質なコンテンツは、それ自体が低評価を受けるだけでなく、サイト全体の評価を引き下げる要因になり、程度によってはアルゴリズムによる自動ペナルティの対象にもなります。逆に言えば、低品質コンテンツを改善または削除してサイトから一掃することで、サイト全体のSEO評価を回復させることができるのです。

低品質なコンテンツを統合や改善することによって高品質なコンテンツに生まれ変わらせることができる場合には、ぜひ改善しましょう。しかし現実の問題として、低品質コンテンツの量が多すぎるなど手に余る場合には、まずは低品質コンテンツを削除し、そのあとで改善が可能なコンテンツの改善へと進みます。

低品質なコンテンツの存在はサイトのSEOにとって大きなマイナスです。その根底にある考え方は「質の低いページを含むサイトは最高の品質を備えたサイトであるとは評価できない」というものです。Googleはこの考え方に基づいて過去に何度もアルゴリズムのアップデートを行っており、その都度アナウンスもしています。それらを以下に紹介します。

低品質なコンテンツの削除

Googleは2011年2月(日本では2012年7月)に実施したパンダアップデートによって、質の低いコンテンツが掲載されたウェブサイトを狙って順位を引き下げました。その後、パンダアップデートはコア・アルゴリズムに組み込まれて今に至っています。以下はその影響を受けたウェブマスターに対するGoogleのアドバイスです。

ウェブサイトの一部に質の低いコンテンツが掲載されている場合に、サイト全体のランキングに影響が及ぶ可能性があります。そのため、質の低いページを削除する、コンテンツの内容が薄いページを有用なページに統合するか改善する、または質の低いページを別のドメインに移動することによって、コンテンツの質が良くなり、掲載順位が上昇する可能性があることをもう一つの具体的なガイダンスとして提示しています。

質の高いサイトの作成方法についてのガイダンス | Google 検索セントラル ブログ1

では「質の低いコンテンツ」とはどのようなものでしょうか? Google検索品質評価ガイドライン2によれば「ほとんどのページにおいてコンテンツの品質は、コンテンツ作成に費やされた労力の量、独自性、才能や技量で判断できる」といいます。その判断基準をまとめたものが次のリストです。

- 労力の量 – 満足のいくコンテンツを作るために費やされた作者の労力はどれくらいか。

- 独自性 – 他のサイトにはない固有の独創的なコンテンツはどれくらいあるか。

- 才能か技量 – 訪問者に満足な体験を提供するためにコンテンツに使われた才能や技量はどれくらいか。

- 正確性 – コンテンツの正確さはどれくらいか。

低品質コンテンツとはつまり、上記の各項が十分でないものを指します。十分に労力が費やされておらず、他のサイトのコンテンツと似たり寄ったりで、才能も技量も使われておらず、正確性を証明することをしていないコンテンツが、低品質コンテンツです。先の引用の通り、低品質なコンテンツは改善するか削除する必要があります。

有用でないコンテンツの削除

先述のパンダアップデートによる低品質コンテンツを含むサイトを対象としたアルゴリズム調整に加えて、Googleは2022年8月、新たにヘルプフル・コンテンツ・アップデートを実施し、有用でないコンテンツを含むサイトの掲載順位を下げるようにアルゴリズムを調整をしました。Googleによるその説明が次の引用です。

有用でないコンテンツ自体だけでなく、そうしたコンテンツを比較的多く含むと判断されたサイトにあるコンテンツも、表示すべきコンテンツがウェブの他の場所にあると考えられ、検索での掲載順位が下がります。そのため、有用でないコンテンツを削除することで、他のコンテンツのランキングが改善する場合があります。

2022 年 8 月の Google の有用なコンテンツの更新についてクリエイターが知っておくべきこと | Google 検索セントラル ブログ3

有用でないコンテンツとは、検索を行うユーザーにとって有用ではないコンテンツを指しています。検索は質問の一種ですから、質問に対する答えを提供しないタイプのコンテンツは有用ではないと考えてよいでしょう。それらをサイトから一掃することで、検索順位におけるマイナス評価から回復させることができます。

E-E-A-Tの低いコンテンツの削除

Googleのジョン・ミューラーによれば、同じサイトの中にE-E-A-Tの高いコンテンツと低いコンテンツが混在していた場合、Googleがサイトを評価することが困難になる可能性があるといいます4。つまり、サイト内に低E-E-A-Tコンテンツが含まれていた場合、Googleがそのサイトを次のどちらとして評価するかは制御できないということです。

- パターン1:このサイトには信頼性の高いコンテンツが多く、大まかに言えば高品質なサイトであるため、検索結果の高いランキングに値する。

- パターン2:このサイトには信頼性の低いコンテンツが混在しているため、全体としての信頼度は最高とは言えず、検索結果での高いランキングには値しない。

この解決策は、Googleによる評価の前にウェブマスターの側であらかじめ、低E-E-A-Tコンテンツを削除するか、別のドメインまたはサブドメインに隔離しておくことです。例えば、サイト内に他愛のないランチ日記やゴルフ日記が含まれていた場合、それらをサイトから削除するか外部ブログなどに移設することで、サイトの高いE-E-A-Tが維持できます。

期待できる結果(事例紹介)

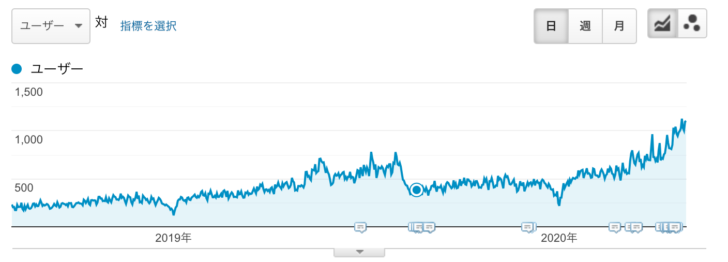

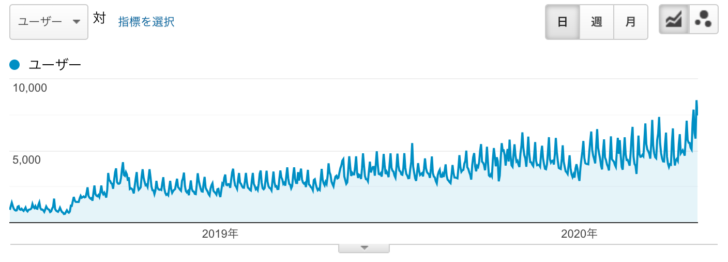

ここでは2つの事例を確認します。以下に紹介する2枚のスクリーンショットはいずれも、低品質コンテンツの改善と削除を中心とした施策で結果を出した例であり、またグラフは検索流入だけの推移を示したものです。いずれの場合も、業務との関連性の低い日記などのコンテンツを大量に削除し、内容の薄い記事を統合しています。

例1(検索流入が約4倍に)

上の画像のサイトは、URLを正規化(不正なサイトマップの修正と自己参照canonicalリンクタグの挿入)し、低品質コンテンツを削除し、いくつかの記事を統合、また、増え続ける類似のお知らせページをカテゴリまるごとnoindex化したものです。季節的な変動もあるものの、検索流入はおよそ4倍に増えています。

いくつかの業界では、パンダアップデート以前(つまり2012年以前)の時代に「内容がどうであれページ数は多ければ多いほどSEO効果がある」という誤情報が拡がったそうで、このサイトも闇雲にページ数を増やしていました。こうしたコンテンツを削除することで、本来のSEOの効果が得られるようになります。

例2(検索流入が約15倍に)

上の画像のサイトは、低品質コンテンツを削除し、いくつかのコンテンツを統合、その後は少しずつ高品質なコンテンツを追加し続けているものです。その結果、検索流入は15倍ほどに増えています。後半の流入の伸びは新規に追加した高品質コンテンツの影響が大きいのですが、それも低品質コンテンツの削除が奏効した結果であると言えます。

サイト内に低品質なコンテンツが多く残った状態では、サイト全体の評価がマイナスに引っ張られるため、高品質なコンテンツを追加してもそのSEO効果は限定的になってしまいます。このケースでは、高品質なコンテンツを追加していく前に低品質なコンテンツを削除しておいたことにより、高品質なコンテンツのプラス評価を最大化できたものと考えています。

作業内容と手順

実際の作業では多くの場合、コンテンツの改善にかかる前に、まずは改善の見込みのない不要なコンテンツを削除することから始めます。筆者のクライアント層のように長年にわたって内製でSEOを実施してきたサイトには、改善するには手に負えないほどの量の不要なコンテンツが蓄積されているのが普通だからです。

低品質コンテンツの削除は、筆者が新規の案件に着手するとき、まず最初に実施する(指示する)代表的なSEO施策の一つです。サイト内のすべてのコンテンツを高品質に保つことは、低品質コンテンツをすっかり削除することと表裏一体であり、SEO施策の基礎をなすものだからです。

低品質なコンテンツ、不要なコンテンツを削除してから、残った記事を統合したり情報を付け加えたりといった改善を行います。多くの場合、コンテンツ数は大幅に減ります。先に紹介した例では、前者では半分弱のコンテンツを削除し、後者では9割以上のコンテンツを削除しています。そのような大改革を経て、SEO的に強靱なサイトに生まれ変わるのです。

関連性の低い記事を削除する

企業サイトの不要なコンテンツを選別する作業は、個人のブログとは異なり、非常に単純です。企業サイトの場合は「見込み客の関心に沿ったコンテンツであるかどうか」だけを基準に選別すればよいからです。例えば、次のようなコンテンツがサイト内にある場合、削除の対象としてよいでしょう。

- 自社の専門外のトピックを扱うコンテンツ – 自社の製品やサービスと無関係な、専門分野外のトピックを扱っている。例えば平日のランチ日記や、休日のゴルフ日記、社長仲間との飲み会日記などのコンテンツがそれに該当します。

- ターゲットを外したトピックを扱うコンテンツ – 見込客が直面している課題や問題、悩みや困りごとと関連のないトピックを扱っている。例えば書き手自身の趣味についての情報や考察など、見込客や潜在客の関心に沿わないコンテンツがそれに該当します。

企業サイトのコンテンツは見込客または潜在客を呼び寄せるものである必要があります。逆に言えば、見込客でも潜在客でもない人々を呼び寄せるコンテンツは不要です。見込客や潜在客の関心に合わないコンテンツを置いておくことには次のようなデメリットがあり、単に不要であるというだけでなく、マイナス評価の原因となります。

- ユーザー行動シグナルの悪化 – 事業との関連性の低いコンテンツがあると、直帰率の上昇や滞在時間の短縮などユーザー行動によるシグナルが悪化することによる順位低下のおそれがある。

- テーマ性や専門性の毀損 – 事業との関連性の低いコンテンツがあると、サイトのテーマ性や専門性による加点が得られなくなる。

もしアクセス数が多かったり被リンクが得られてるコンテンツだったとしても、そのトピックが自社が扱う製品やサービスとの関連が薄いなら、削除して構いません。逆に、自社が扱う製品やサービスと関連があり、見込み客の関心に沿うコンテンツなら、アクセスが少なくても被リンクがなくても残しておき、良質なコンテンツへと改善するべきです。

なお、日記などの軽い内容の投稿や、個人的な趣味にまつわる投稿を今後も続けたい場合のおすすめは、SNSに投稿することです。アメブロやnoteなど外部サービスを使うのもいいでしょう。それらの投稿も、会社のサイト内にさえ置かなければ、SEOへのマイナス影響はありません。個人の活動は外部サービスの個人アカウントでやりましょう。

改善が不可能な記事を削除する

古すぎるなどの理由で改善のしようがないコンテンツを削除します。コンテンツによってはnoindexを指定するなどして残すケースもありますが、可能であればすっぱりと削除してしまうほうが、後々のメンテナンスが楽になるためおすすめです。ここでは次のようなコンテンツが削除の対象です。

- 古いお知らせ記事のうち重要でないもの(休業日や入荷情報のお知らせなど)

- 今は販売されていない製品(PHSやブラウン管テレビなど)の購入ガイド

- 現時点で見返すと酷すぎて手の施しようがないと思えるもの

このような不要なコンテンツを削除する作業を先にやっておくことで、次項以降のコンテンツ改善作業に要する労力が大きく減少します。既存コンテンツの改善作業は非常に手間のかかるものですので、関連性の低い記事の削除と、改善が不可能な記事の削除は、できるだけしっかりとやっておくといいでしょう。

残った記事を高品質なものに改善する

ここまでの作業で、記事数は大幅に削減できたはずです。あとは残った記事を改善し、高品質なコンテンツに生まれ変わらせていくだけです。見込客や潜在客に時間を割いて見てもらうにふさわしい、検索意図をよく満たすコンテンツだけが揃ったサイトへと改善できれば、事例で示したとおりの結果が得られます。作業内容は次の通りです。

- 同じトピックの記事をまとめる – 同じトピックを扱う記事がサイト内にいくつも分散して存在していることは珍しくありません。それらを1記事にまとめて、内容の濃い役立つ記事に書き換えましょう。

- 独自の価値を提供する – 同じキーワードで検索して上位に表示される他サイトの記事と比較したとき、独自の内容に乏しいようなら、自身の経験や自社の事例、それらから得られる独自の視点など、独自の情報をさらに追加しましょう。

- 出典を示し正確性を担保する – 自分が生み出したものではない情報を記載するときには信頼できる出典を示し、情報の正確性を担保すると同時に、剽窃を回避(他人のアイデアを自分のアイデアであるかのように発表すれば剽窃にあたります)します。

- 記事としての体裁を整える – タイトル、見出し、パラグラフなどを適切に使って体裁を整えるほか、誤字脱字や文法ミス、リンク切れなどがないように校正します。構成や文章が乱れていて、急いで書き飛ばしたように見えれば、読者の信頼を失います。

- 古くならないようにメンテナンスし続ける – 改善した時点では素晴らしい記事に仕上がっていても、そのまま放っておけば、時間の経過や環境の変化によって記事の内容は古くります。新しさを保つために、定期的にメンテナンスするようにします。

サイトのコンテンツをメンテナンスするために割ける人的リソースに対してコンテンツ数が多すぎれば、コンテンツのメンテナンスはどうしても滞ります。個人的には、記事を量産するよりも少数精鋭の既存記事のメンテナンスに注力し、数は少なくてもすべてのコンテンツを高品質に保つほうが、中小企業のサイトにはふさわしいと考えます。

まとめ

冒頭で紹介したパンダ・アップデートやヘルプフル・コンテンツ・アップデートは、極端に低品質なコンテンツを含むサイトに影響するとされています。この記事の読者のサイトには、スパムまがいの極端な低品質コンテンツは始めから存在していないでしょう。それでも、比較的低品質なコンテンツを削除し、サイト全体を高品質に保つことは、SEOにとって重要です。

なぜなら、Googleはサイト内に含まれている低品質コンテンツがごく少数だけだったとしてもそれを検知しますし、そうしたものを掲載するサイトに高評価を与えません。また、低品質なコンテンツは直帰率を上昇させ、サイトでの滞在時間を短縮するなど、ユーザー行動にマイナスの影響を与えます。この点もサイトの評価を下げる要因です。

できる限りの最高のコンテンツを提供することに集中してください。それこそが、私たちのアルゴリズムが報いようとしていることなのです。

What site owners should know about Google’s August 2019 core update5

Googleのアドバイスは上記の通りです。品質が十分でないコンテンツの存在はSEOのマイナス要因です。サイト上にはできる限りの最高のコンテンツだけを揃えましょう。そのために、低品質なコンテンツを削除または改善しましょう。あなたが既存のコンテンツの品質を最後に確認したのはいつでしょうか? そろそろまた始める時期かもしれません。

脚注

- 質の高いサイトの作成方法についてのガイダンス | Google 検索セントラル ブログ ↩︎

- Google Search Quality Ratings Guidelines(2022年12月版) ↩︎

- 2022 年 8 月の Google の有用なコンテンツの更新についてクリエイターが知っておくべきこと | Google 検索セントラル ブログ ↩︎

- English Google SEO office-hours from April 9, 2021 – YouTube ↩︎

- What site owners should know about Google’s August 2019 core update | Google Search Central Blog ↩︎